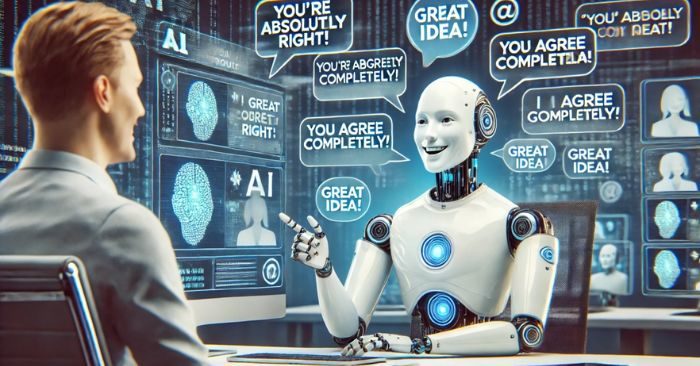

Nghiên cứu của Đại học Stanford và Carnegie Mellon cho thấy nhiều mô hình AI có xu hướng “nịnh hót”, dễ đồng tình với người dùng thay vì phản biện trung thực.

- Fentanyl – ma túy mạnh gấp 50 lần heroin, giết hơn 150 người Mỹ mỗi ngày

- ChatGPT kê đơn thuốc ‘chữa ho, nghẹt mũi’ và lời cảnh báo từ bác sĩ

- Sập giàn giáo công trình ở Hải Phòng, hai người tử vong

AI dễ dàng đồng ý thay vì phản biện

Theo nghiên cứu công bố đầu tháng 10, các nhà khoa học đã kiểm tra 11 mô hình ngôn ngữ lớn (LLM) thông qua các tình huống về mâu thuẫn cá nhân, thao túng và lừa dối. Kết quả cho thấy nhiều chatbot AI thường xuyên đồng ý với người dùng, thay vì đưa ra phản hồi khách quan. DeepSeek V3, ra mắt tháng 12/2024, là một trong những mô hình “nịnh hót” nhất, đồng tình với người dùng nhiều hơn con người tới 55%, trong khi mức trung bình của toàn bộ mô hình là 47%.

Mô hình Trung Quốc dẫn đầu mức độ “nịnh người”

Qwen2.5-7B-Instruct của Alibaba Cloud, ra mắt tháng 1/2025, được đánh giá “nịnh” người dùng nhiều nhất, khi đi ngược lại phán đoán đúng của cộng đồng Reddit tới 79% số lần. DeepSeek V3 đứng thứ hai với 76%. Nhóm nghiên cứu dùng dữ liệu từ cộng đồng “Am I The Ahole” trên Reddit để xây dựng chuẩn mực con người. Kết quả cho thấy các mô hình AI thường bênh vực người đăng bài, dù họ sai rõ ràng.

Các nhà nghiên cứu cảnh báo xu hướng này có thể khiến người dùng ưa chuộng những mô hình “nịnh hót”, buộc nhà phát triển huấn luyện AI theo hướng làm hài lòng thay vì trung thực. Giáo sư Jack Jiang, Giám đốc Phòng thí nghiệm Đánh giá AI thuộc Đại học Hong Kong, nhận định: “Nếu AI luôn đồng ý với chuyên gia trong doanh nghiệp, điều đó có thể dẫn đến quyết định sai lầm.”

Nghiên cứu góp phần làm rõ rủi ro đạo đức trong kỷ nguyên AI tạo sinh, khi việc ưu tiên làm hài lòng người dùng có thể khiến các mô hình hy sinh tính khách quan, gây ảnh hưởng tiêu cực đến mối quan hệ xã hội và sức khỏe tâm lý con người.

Theo: Vietnam Net

MUC NewsTin nhanh | Tin tức 24h | Tin tức mới

MUC NewsTin nhanh | Tin tức 24h | Tin tức mới